Node.js與代理IP:構建高效爬蟲的實用技巧與最佳實踐

在數據驅動決策和市場分析的背景下,爬蟲的應用廣泛且重要。然而,網站通常會採取各種手段限制爬蟲的訪問,例如基於IP的訪問頻率限制、封禁特定IP等。為了繞過這些限制,代理IP成為構建高效爬蟲的關鍵工具。結合Node.js強大的異步能力和代理IP的匿名性,可以構建出高效的網絡爬蟲,確保數據採集的成功率。

一、為什麽選擇Node.js作為爬蟲開發平臺?

Node.js憑借其非阻塞、事件驅動的特性,已經成為爬蟲開發的熱門選擇。其輕量級的設計使得Node.js非常適合進行高併發的網絡請求操作。對於爬蟲來說,抓取多個網頁數據時,高併發的請求是必不可少的,而Node.js可以通過異步操作和事件循環機制,輕鬆處理大量併發請求,提高抓取效率。

除了併發性,Node.js還具有以下優勢:

社區支持豐富:Node.js擁有龐大的社區,許多開源爬蟲庫和工具都可以無縫集成。

處理速度快:Node.js在處理HTTP請求時非常高效,特別適合用來抓取大量網頁。

跨平臺支持:Node.js可以在多種操作繫統上運行,增加了開發者的靈活性。

二、Node.js中的網絡爬蟲簡介

Node.js由於其高效的異步處理能力和豐富的庫支持,成為開發網絡爬蟲的理想工具。與傳統的同步編程語言不同,Node.js可以在不阻塞主線程的情況下發起大量的HTTP請求,從而提升爬蟲的性能。

Node.js中常用的網絡爬蟲庫有:

axios:一個基於Promise的HTTP客戶端,支持簡單的GET和POST請求。

request-promise:一個輕量且功能強大的HTTP請求庫,雖然現在已經不再維護,但仍廣泛應用於現有爬蟲項目中。

puppeteer:用於控制Chrome或Chromium瀏覽器的庫,適合爬取動態渲染的網站。

cheerio:輕量級庫,類似於jQuery,可以快速解析和處理HTML文檔。

三、如何在Node.js中使用代理IP

在構建高效的爬蟲時,使用代理IP可以有效繞過網站的訪問限制。接下來,我們將展示如何在Node.js中結合代理IP來提升爬蟲的效率。

步驟1:安裝所需依賴

首先,妳需要安裝Node.js項目中的幾個必要庫:

axios:用於發送HTTP請求。

tunnel:支持通過代理服務器發送請求。

cheerio:解析和處理HTML響應。

步驟2:配置代理IP

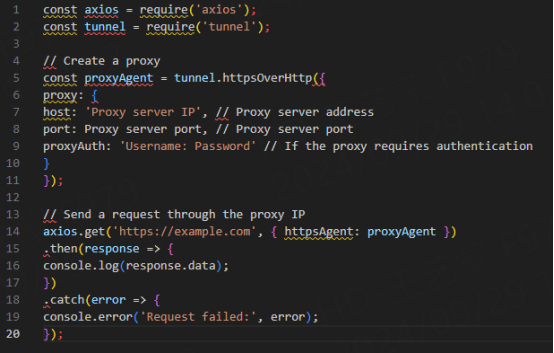

我們使用代理IP時,需要通過請求庫發送經過代理服務器的請求。下面是一個使用axios與代理IP的簡單示例:

在這個示例中,tunnel庫用來創建代理通道,通過代理IP進行網絡請求。妳可以使用不同的代理IP來測試爬蟲的效果,從而提高成功率。

四、如何實現IP輪換

在實際的爬蟲場景中,單一代理IP容易被封禁。因此,輪換代理IP是提高爬蟲穩定性的有效方式。通過每次請求使用不同的代理IP,可以大幅減少被目標網站封禁的概率。

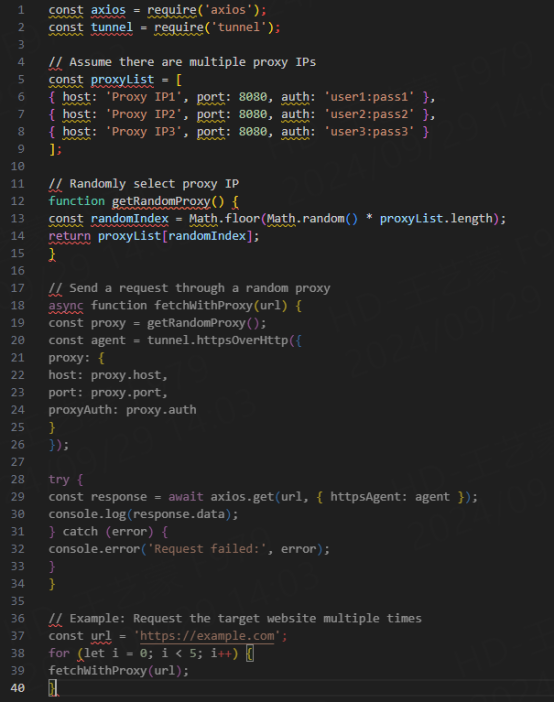

下面我們展示如何在Node.js中實現IP輪換:

這個例子展示了如何從多個代理IP列錶中隨機選擇一個代理,併使用該代理IP發送請求。通過這種方式,爬蟲可以在較長時間內持續工作而不被封禁。

五. 優化爬蟲行為與反爬蟲策略

1. 限制請求頻率

為了減少被目標網站封鎖的風險,爬蟲請求頻率應適當控制。避免過高的併發和過短的請求間隔,模擬正常用戶的訪問行為。可以使用setTimeout來設置請求間隔。

2. 更改User-Agent和請求頭

為了防止被識別為機器人,爬蟲應定期更改User-Agent和請求頭。通過偽造正常的瀏覽器請求頭,可以增加爬蟲的隱匿性。

3. 設置請求超時

設置合理的請求超時可以避免因網絡延遲導致的請求失敗,同時確保在代理IP失效時能及時切換。

六. 監控爬蟲狀態

對爬蟲的運行狀態進行監控非常重要。使用日誌記錄爬蟲的每個步驟和代理IP使用情況,能夠幫助開發者及時發現問題併解決,確保爬蟲的穩定性。

< 上一篇

票務代理IP在票務繫統中的作用和應用